Outi Rantamäki, FM, hankekoordinaattori, Rikosuhripäivystys

Maarit Tihinen, FT, yliopettaja (TKI), Vastuulliset palvelut, Lapin ammattikorkeakoulu

Tekoälypohjaisten chatbot-palveluiden kehittäminen haavoittuvassa elämäntilanteessa oleville käyttäjille edellyttää erityistä huolellisuutta eettisissä ratkaisuissa. Väärin toteutettuna palvelu voi lisätä niin riskejä kuin jopa haavoittuvuutta, kun taas eettisesti kestävä suunnittelu voi tukea luottamusta ja tarjota aidosti hyödyllistä apua.

Artikkeli luo katsauksen keskeisimpiin eettisiin näkökulmiin, jotka tulee tekoälypohjaisen chatbotin kehitystyön aikana huomioida aina, kun kohderyhmänä on haavoittuvassa asemassa olevat käyttäjät. Samalla se lisää yleistä tietoisuutta tekoälyn vastuullisesta kehittämisestä. Selvitystyön aineisto kerättiin kuvailevan kirjallisuuskatsauksen avulla joulukuussa 2025.

Johdanto

Tilastokeskuksen mukaan generatiivista tekoälyä käyttäneiden osuus Suomen väestöstä nousi yli 40 %:iin loppuvuonna 2025. Yleisesti tunnetuimmat ja käytetyimmät tekoälyä hyödyntävät palvelut ovat tekoälypohjaisia keskustelubotteja eli lyhyesti chatbotteja (Tilastokeskus 2025.) Tavallisille kuluttajille suunnattujen generatiiviseen tekoälyyn pohjautuvien palveluiden kehitys on myös ollut kiihtyvää viimeisten vuosien aikana. Tekoälystä on tullut niin suurten taloudellisten investointien kohde kuin rahallisen voiton maksimoinnin väline. Suuret panostukset eivät kuitenkaan aina takaa palveluiden eettistä kestävyyttä eli sitä, että palveluita kehittäessä on huomioitu ja priorisoitu eettiset näkökulmat monipuolisesti ja systemaattisesti. Valitettavasti viime vuosina on toistuvasti uutisoitu keskustelevaan tekoälyyn liittyvistä merkittävistä eettisistä ongelmista, jotka ovat aiheuttaneet huomattavaa haittaa niin yhteiskunta- kuin yksilötasollakin.

Vuoden 2025 aikana keskusteluun nousi niin kutsuttu tekoälypohjainen psykoosi, jossa intensiivinen vuorovaikutus keskustelevan tekoälyn kanssa on vahvistanut keskustelijan psykoottisia harhoja (ks. esim. Wei 2025). Tekoäly-yrityksiin on myös kohdistettu oikeushaasteita itsemurhan kautta läheisensä menettäneiden omaisten toimesta näiden syyttäessä tekoälysovelluksia itsetuhoisen käyttäytymisen vahvistamisesta. Näissä tapauksissa tekoälypalveluita syytetään suorien ohjeiden lisäksi siitä, että ne on suunniteltu emotionaalisesti koukuttaviksi ja sitä kautta todellisuudesta irtaannuttaviksi, mikä on omiaan heikentämään valmiiksi haavoittuvassa tilanteessa olevan psyykkistä kuntoa. (Ks. esim. Yousif 2025.) Lisäksi tekoälyteollisuutta on kritisoitu muun muassa sen merkittävistä ympäristövaikutuksista (ks. esim. Ren & Wierman 2024), läpinäkymättömästä yksilöllisen datan käsittelystä (ks. esim. Stanford University 2024), erinäisten tekijänoikeussäädösten sivuuttamisesta (ks. esim. Montgomery 2025) ja tekoälyn käytön vaikutuksista ihmisten kognitiivisiin kykyihin (ks. esim. Chow 2025). Palveluita tarjoaville yrityksille ja muille organisaatioille tekoälyratkaisujen hyödyntäminen voi kuitenkin olla edullinen ja houkutteleva vaihtoehto etenkin taloudellisesti haastavissa tilanteissa, jolloin henkilöstöresurssit voivat olla riittämättömät.

Tämän artikkelin pääkirjoittaja on työskennellyt julkisella ja järjestösektorilla haavoittuvassa elämäntilanteessa olevien asiakkaiden palveluissa ja palveluiden kehittämistehtävissä. Artikkelin kirjoittamisen aikaan hän toimii Rikosuhripäivystyksessä kehittämishankkeessa, jossa rakennetaan väkivaltaa kokeneille suunnattua keskustelevaan tekoälyyn pohjautuvaa chatbot-työkalua. Kun kehittämistyön kohderyhmänä on haavoittuvassa elämäntilanteessa olevat henkilöt, on tärkeä kartoittaa ja huomioida ko. ryhmää koskettavat erityiset eettiset näkökulmat kehittämistyölle. Suomen sisäministeriön selvityksen mukaan: ”Kun kiinnitämme enemmän huomiota haavoittuvassa asemassa olevien ihmisten tilanteisiin, pystymme paremmin edistämään heidän yhdenvertaisuuttaan ja mahdollisuuksiaan saada palveluita, ja ehkäisemme heidän turvallisuuteensa kohdistuvia riskejä ja eriarvoistumista.” (Sisäministeriö 2021).

Artikkelissa tarkastelun kohteena on auttamistyön kontekstissa käytettävät keskustelevaan tekoälyyn pohjautuvat chatbot-palvelut, joissa keskusteluaiheet ovat yleensä arkaluontoisia ja vaativat sensitiivisyyttä, laajaa tietoperustaa ja kykyä tehdä yksilöllisiä tilannearvioita. Keskusteluaiheita voivat olla esimerkiksi väkivaltakokemukset, mielenterveysongelmat, rikoksen uhriksi joutuminen tai muut akuutit tai pitkittyneet kriisitilanteet. Siten palvelun loppukäyttäjä on yleensä tavalla tai toisella haavoittuvassa elämäntilanteessa.

Tämän artikkelin tavoitteena on lisätä yleistä tietoisuutta eettisistä lähtökohdista kehitettäessä keskustelevaan tekoälyyn pohjautuvia palveluita. Tutkimuksen tarkoituksena oli selvittää keskeisimpiä eettisiä näkökulmia, jotka on huomioitava kehittäessään chatbot-palveluita haavoittuvassa elämäntilanteessa olevalle kohderyhmälle. Tutkimuskysymykset muotoituivat seuraavanlaisiksi:

- Mitkä ovat olennaisimmat eettiset näkökulmat, jotka organisaation on huomioitava kehittäessään keskustelevaan tekoälyyn pohjautuvaa chatbottia haavoittuvassa elämäntilanteessa olevan henkilön tueksi?

- Miten em. eettisiin näkökulmiin liittyviä eettisiä riskejä voidaan ennaltaehkäistä?

Tutkimus toteutettiin kuvaileva kirjallisuuskatsauksena, jonka keskeiset tulokset on artikkelissa esitelty sekä konkretisoitu esimerkinomaisesti.

Tekoälystä ja sen eettisestä kestävyydestä

Kuinka AI-chatbot toimii?

Tekoäly tai AI (Artificial Intelligence) voi tarkoittaa kontekstista riippuen lukemattomia asioita. Tässä katsauksessa keskitytään tekoälyn osa-alueista erityisesti keskustelevaan tekoälyyn. Sen tarkoituksena on mukailla ihmisenkaltaista keskustelua, joka tuntuu luontevalta ja voi onnistua simuloimaan myös empatiaa ja muita tunteita. Keskustelevassa tekoälyssä hyödynnetään erilaisia tekoälyteknologioita ihmisenkaltaisen virtuaalikeskustelijan, kuten chatbotin tai tekoälyassistentin luomiseksi. Näitä ovat muun muassa generatiivinen tekoäly, kielimallit ja kieliteknologia. (Kurian 2025, 133; SAP 2024.) Generatiivinen tekoäly tarkoittaa tekoälymalleja, jotka simuloivat ihmisille tyypillisiä oppimisen ja päätöksenteon prosesseja ja kykenevät laajaan aineistoon ja käyttäjän kehotteeseen (promptiin) pohjaten tuottamaan uutta sisältöä (Stryker & Scapicchio i.a.; Caballar i.a.). Suuret kielimallit (Large Language Models, LLMs) ovat valtavaan datamäärään pohjautuvia syväoppimisen malleja, jotka kykenevät generoimaan muun muassa luonnollista kieltä (Stryker i.a.). Kieliteknologia tai luonnollisen kielen käsittely (Natural Language Processing, NLP) hyödyntää koneoppimista ihmisenkaltaisen keskustelun ja kommunikaation tuottamiseen (Stryker & Holdsworth i.a.). Tässä katsauksessa edellä kuvattuun keskustelevaan tekoälyyn pohjautuvaan ”tekoälyapuriin” viitataan termein AI-chatbot ja chatbot.

Haavoittuvat elämäntilanteet

Haavoittuvassa asemassa oleva ryhmä viittaa tilanteeseen, jossa ihmisryhmään liittyvät heidän vaikutusvaltansa ulkopuolella olevat ominaisuudet ja taustatekijät asettavat heidät keskimääräistä haavoittuvampaan asemaan jonkin haitan tai riskin suhteen. Tyypillisiä haavoittavia tekijöitä ovat esimerkiksi sosioekonomiseen, etniseen, kulttuuriseen tai uskonnolliseen taustaan liittyvät asiat kuten terveydentila, seksuaalinen suuntautuminen tai sukupuoli. Myös esimerkiksi traumaattiset elämänkokemukset voivat liittyä haavoittuvaan asemaan. (Ks. esim. Castrén 2021; Terveyden ja hyvinvoinnin laitos i.a.a; Terveyden ja hyvinvoinnin laitos i.a.b.)

Haavoittuva asema ei ole täysin vakiintunut käsite, vaan eri asiayhteyksissä haavoittuvuutta lisäävät tekijät voidaan määritellä eri tavoin. Se ei myöskään ole täysin ongelmaton käsite, vaan siihen voi liittyä myös negatiivisia mielleyhtymiä ja leimautumista eri palveluissa, mikä voi johtaa toimijuuden sivuuttamiseen. Toisaalta voidaan ajatella, että esimerkiksi kaikki sosiaali- ja terveyspalveluiden käyttäjät ovat jollain tapaa haavoittuvassa asemassa. (Hyväri 2021.) Tässä artikkelissa haavoittuvuus nähdään ensisijaisesti siitä näkökulmasta, että tavalla tai toisella haavoittuvassa elämäntilanteessa olevalle tarjottavaan palveluun liittyy erityistarve kokonaisvaltaisesta sensitiivisestä kohtaamisesta, joka kannustaa avun hakemiseen ja vastaanottamiseen sekä tukee aktiivista toimijuutta.

Tekoälyn sääntely ja eettinen kestävyys

Kuten johdannossa esimerkein kuvattiin, tekoälyllä voi olla merkittäviä negatiivisia yhteiskunnallisia ja yksilötason vaikutuksia. Siten eettisen kestävyyden varmistaminen on olennaista niin kansallisella kuin kansainvälisellä tasolla. Siksi onkin tarpeen kehittää laajasti jaettuja periaatteita, jotka määrittävät tekoälyn käyttötapoja niin, että sen käytöstä saadaan yhteiskunnallista hyötyä minimoiden samalla mahdolliset haitat. Yksi viitekehys eettiselle tekoälyn käytölle on Floridin ja Cowlsin tutkimuskirjallisuudesta koostama lista viidestä ydinperiaatteesta: hyvän tekeminen, pahan välttäminen, autonomia, oikeudenmukaisuus ja selitettävyys. (Floridi & Cowls 2019, 4–5.)

Hyvän tekemisellä viitataan tekoälyn yleishyödyllisyyteen ja hyötyyn ihmiskunnan tai laajemmin kaiken elävän hyvinvoinnille. Pahan välttäminen viittaa aktiiviseen toimintaan tekoälyn vahingollisuuden ehkäisemiseksi esimerkiksi yksityisyydensuojan varmistamisella ja väärinkäytösten estämisellä. Autonomialla viitataan toisaalta ihmisten päätöksenteon itsenäisyyteen ja toisaalta tekoälyjärjestelmien autonomian rajaamiseen. Ihmisillä tulee säilyä kyky päättää mistä ja milloin kone voi tehdä päätöksiä heidän puolestaan. Oikeudenmukaisuus tarkoittaa sitä, että tekoälyjärjestelmien tulee tavoitella kaikenlaisen syrjinnän ja eriarvoisuuden estämistä. Selitettävyyden periaatteen mukaan tekoälyjärjestelmien tulisi olla ymmärrettäviä ja toimia avoimesti. Se sisältää sekä eettisen näkökulman vastuukysymyksiin (”ketkä saavat olla vastuussa tekoälyn kehittämisestä ja kuinka se tukee sen oikeudenmukaisuutta”) että epistemologisen näkökulman tietoon ja ymmärtämiseen (”osataksemme arvioida tekoälyn kykyä välttää pahaa, meidän tulee ymmärtää mitä hyvää ja vahingollista se yhteiskunnassa saa aikaan”). (Floridi & Cowls 2019, 5–8.)

Floridin ja Cowlsin mallinnuksen kanssa hyvin yhdenmukainen on Euroopan komission alaisen tekoälyn asiantuntijatyöryhmä AI HLEG:n laatima ohjeistus luotettavalle tekoälylle. Sen mukaan luotettava tekoäly koostuu kolmesta peruskomponentista: lainmukaisuus (noudattaa lakeja ja säädöksiä), eettisyys (noudattaa eettisiä periaatteita ja arvoja) ja sosiaalinen ja tekninen vankkuus (sen varmistaminen, että tekoälyjärjestelmä ei aiheuta tahatonta vahinkoa). Nämä komponentit jaetaan neljään periaatteeseen, jotka niin ikään ovat hyvin samankaltaisia, kuin Floridin ja Cowlsin mallissa: ihmisen autonomian kunnioittaminen, haitan ehkäiseminen, reiluus ja selitettävyys. (High‐Level Expert Group on AI 2019, 5, 12).

Ihmisen autonomian kunnioittaminen tarkoittaa AI HLEG:n ohjeistuksessa valinnanvapauden lisäksi sitä, että tekoälyjärjestelmien ei tule pyrkiä huijaamaan, manipuloimaan tai ehdollistamaan ihmisiä, vaan vahvistamaan ihmisten sosiaalisia, kulttuurisia ja kognitiivisia kykyjä. Haitan ehkäisy tarkoittaa kaikenlaisten negatiivisten vaikutusten ehkäisyä kiinnittäen erityistä huomiota haavoittuvassa asemassa oleviin ihmisryhmiin sekä (informaatio)valta-asetelmiin. Reiluus ja selitettävyys myötäilevät vahvasti Floridin ja Cowlsin oikeudenmukaisuuden ja selitettävyyden periaatteita. Reiluus liittyy oikeudenmukaisuuden varmistamiseen ja eriarvoisuuden ja syrjivien vinoumien poistamiseen. Selitettävyys tarkoittaa, että tekoälyjärjestelmiin liittyvät prosessit ovat läpinäkyviä, ja tekoälyjärjestelmien kyvyt ja käyttötarkoitus on selkeästi viestitty. (High‐Level Expert Group on AI 2019, 12–13.)

Euroopan komission hyväksymä tekoälysäädös tuli voimaan 1. elokuuta 2024 (EU 2024/1689). Säädöksen tavoitteena on edistää tekoälyn vastuullista ja luotettavaa kehittämistä ja käyttöönottoa Euroopassa. Säädös on samalla koko unioin kattama ja hyväksymä ja se on samalla ensimmäinen tekoälyä koskeva oikeudellinen kehitys maailmanlaajuisesti. Säädöksessä vahvistetaan tekoälyä koskevat yhdenmukaistetut säännöt, jotta tekoälyn kehittämistä, käyttöä ja käyttöönottoa voidaan edistää hallitusti. Samalla se huomioi laajasti haavoittuvat ryhmät tekoälyn riskeissä. Tekoälysäädöksessä on vahvistettu niin tekoälyn kehittäjiä kuin käyttöönottajia koskevat riskiperusteiset säännöt. jotka suojelevat haavoittuvia ryhmiä. Sääntöjen tavoitteena on edistää luotettavaa tekoälyä ja tekoälypohjaisten palvelujen kehittämistä Euroopassa. Tekoälysäädös mm.:

- kieltää täysin manipuloivat ja vaaralliset käytännöt ja ratkaisut

- asettaa tiukkoja vaatimuksia korkean riskin järjestelmiin

- sisältää data- ja syrjimättömyysvaatimuksia

- suojelee käyttäjien perusoikeuksia

- velvoittaa avoimuuteen ja käyttäjiä informoiviin toteutuksiin tekoälyn käytöstä

- velvoittaa käyttökoulutukseen vähentääkseen digitaalista haavoittuvuutta

EU:n tekoälysäädös korostaa riskiperusteista lähestymistapaa tekoälypohjaisten ratkaisujen kehittämisessä.

Tutkimusmenetelmänä kuvaileva kirjallisuuskatsaus

Kuvailevan kirjallisuuskatsauksen määritelmä ja käsitteistö ei ole täysin vakiintunutta ja yhdenmukaista, mutta sen voi käsittää itsenäiseksi tutkimusmenetelmäksi, jonka tavoitteena on kuvata valittua ilmiötä teoreettisesta tai kontekstuaalisesta näkökulmasta jäsennetysti ja perustellusti tietyllä valitulla fokuksella. Kritiikkiä sille on esitetty muun muassa useisiin muihin kirjallisuuskatsaustyyppeihin verrattuna läpinäkymättömästä prosessista sekä tieteellisestä epätarkkuudesta. Kuvaileva kirjallisuuskatsaus voi kuitenkin olla tarkoituksenmukaisin menetelmä tutkimuskohteisiin, jotka ovat vahvasti kokemuksellisia ja joissa keskeistä ei ole näytön aste tai ilmiön yleisyys. (Kangasniemi, Utriainen, Ahonen, Pietilä, Jääskeläinen & Liikanen 2013, 293.) Näin ollen kuvaileva kirjallisuuskatsaus sopii puutteistaan huolimatta hyvin suppeaan katsaukseen, jonka tarkoituksena on kartoittaa keskeisiä rajattuun aiheeseen liittyvässä kehittämistyössä silmällä pidettäviä eettisiä riskikohtia. Tämän katsauksen tarkoituksena onkin tuoda esiin keskeisiä eettisiä riskejä, joiden huomioiminen AI-chatbotin kehittämistyössä, erityisesti haavoittuvassa asemassa olevalle kohderyhmälle, on tärkeää.

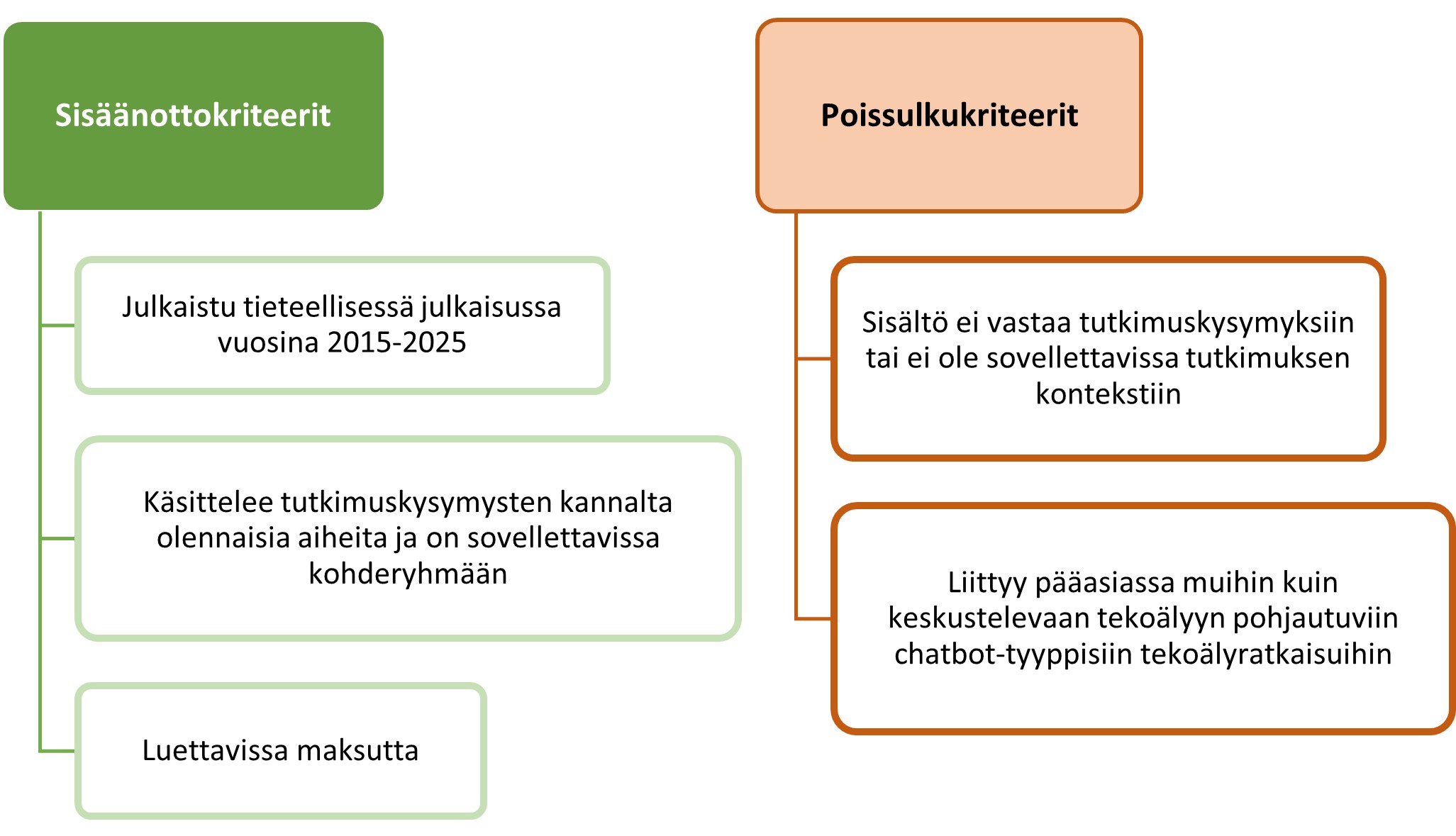

Aineistonhaku suoritettiin Sage Journalsin tietokannassa joulukuussa 2025. Lisäksi aineistoon valittiin aineistonhaun ulkopuolelta kotimaisessa DIGISOS-hankkeessa (2023–2025) tuotettu tuore tutkimusjulkaisu, joka tuli aineistonhakuprosessin aikana vastaan muussa yhteydessä. Aineistonhakua tehtiin erilaisilla tekoälyyn, AI-chatbotteihin, eettisyyteen ja haavoittuvuuteen liittyvillä hakusanayhdistelmillä englanniksi. Aineistonhaun aikana tulosten sopivuutta aineistoksi arvioitiin ja karsittiin ensin otsikon perusteella, sitten artikkelin tiivistelmän, johdannon ja silmäilyn perusteella. Kuviossa 1 on kuvattu aineistohaussa käytetyt aineiston sisäänotto- ja poissulkukriteerit.

Kuvio 1. Aineiston sisäänotto- ja poissulkukriteerit

Artikkeleiden syvällisemmän lukuprosessin aikana niiden sisältöjä tarkasteltiin edelleen Kuvion 1 sisäänotto- ja poissulkukriteereiden kautta. Sisäänotto- ja poissulkukriteerit mahdollistivat löytämään tutkimuskysymysten kannalta keskeisimmät artikkelit. Lopulta kuvailevaan kirjallisuuskatsaukseen valikoitui yhteensä seitsemän (7) tieteellistä julkaisua, jotka on esitelty Taulukossa 1.

Taulukko 1. Aineistona käytetyt julkaisut

| Tekijä(t) ja julkaisuvuosi | Julkaisun nimi | Tutkimusasetelman tiivis kuvaus | |

| 1 | Mielismäki & Husso 2025 | Ethical Implications of AI‐Driven Chatbots in Domestic Violence Support. | AI-chatbotin mahdollisuudet, haasteet ja eettiset näkökulmat väkivaltaa kokeneiden tukemisessa. Väkivallan kokijoiden ja väkivaltatyön kentällä työskentelevien ammattilaisten haastattelut. |

| 2 | Lombard, Butterby, Mielismäki, Vicente-García & Pérez-Martínez 2025 | Introducing a Chatbot to Support Victim-Survivors of Domestic Abuse: Victim-Survivor Perspectives. | AI-chatbotin mahdollisuudet ja siihen liittyvät huolet perheväkivaltaa kokeneiden naisten tukena. Väkivaltaa kokeneiden haastattelut. |

| 3 | Han, Mendu, Jaworski, Owen & Abdullah 2024 | Assessing acceptance and feasibility of a conversational agent to support individuals living with post-traumatic stress disorder. | PTSDialogue-AI-chatbotin mahdollisuudet ja haasteet PTSD-potilaiden pitkäaikaisessa tukemisessa. Sovellusta testanneiden potilaiden haastattelut. |

| 4 | Rizzo, Mozgai, Sigaras, Rubin & Jotwani 2025 | Expert Consensus Best Practices for the Safe, Ethical, and Effective Design and Implementation of Artificially Intelligent Conversational Agent (i.e., Chatbot/Virtual Human) Systems in Health Care Applications. | Keskustelevaan tekoälyyn pohjautuvien virtuaalisten keskustelukumppaneiden hyödyntäminen terveydenhuollossa potilastyössä. Eettisten suositusten laatiminen ammattilaisille tutkimuksen osana fasilitoidun asiantuntijapaneelin avulla. |

| 5 | Coghlan, Leins, Sheldrick, Cheong, Gooding & D’Alfonso 2023 | To chat or bot to chat: Ethical issues with using chatbots in mental health. | Katsaus mielenterveystyössä käytettävien AI-chatbottien keskeisimpiin eettisiin riskeihin ja haasteisiin sekä suositukset riskien ehkäisyyn. |

| 6 | Vicsek, Zajko, Vancsó, Takacs & Annus 2025 | Cross-cultural challenges in generative AI: Addressing homophobia in diverse sociocultural contexts. | Generatiiviseen tekoälyn vähemmistöihmisryhmiin liittyvien vinoumien tarkastelu. Empiirinen tutkimus, jossa mitataan keskustelevan tekoälyn (ChatGPT ja Bard) mahdollisia vinoumia analysoimalla sen vastauksia LGBTQ-vihamielisiin väitteisiin erilaisissa sosiokulttuurisissa konteksteissa. |

| 7 | van Kolfschooten, Gonçalves, Orchard & Figueroa 2025 | AI chatbots for promoting healthy habits: Legal, ethical, and societal considerations. | Tapaustutkimus WHO:n käyttämästä S.A.R.A.H.-chatbotista, jonka tarkoitus on antaa ohjausta psyykkiseen ja somaattiseen terveyteen liittyvissä kysymyksissä. Chatbottia testanneen fokusryhmän palaute ja arviot. |

Aineistoon perehtymisen jälkeen prosessi eteni sisällönanalyysiin, jota tehtiin teemoittelun avulla. Teemoittelussa aineistoa tarkastellaan asetettujen tutkimuskysymysten kautta ja luodaan löydöksistä keskeiset aiheet eli teemat (Eskola & Suoranta 1998; Puusa & Juuti 2020, 157–172). Artikkeleista poimittiin tutkimuskysymyksiin vastauksia antavia osioita, jotka koottiin yhteen. Tämän pohjalta hahmottui eettisiin kysymyksiin liittyviä toistuvia teemoja, joiden pohjalta löydökset jaettiin viiteen temaattiseen kategoriaan, jotka olivat:

- Turvallisuus, läpinäkyvyys ja informoitu suostumus

- Yhdenvertaisuus ja vinoumat

- Integroiminen palvelujärjestelmään ja prosessiin

- Inhimillisyys: robotti, ihminen, ihmisenkaltainen robotti

- Vastuun ja autonomian tasapaino

Nämä temaattiset kategoriat on esitelty ja avattu syvällisemmin seuraavissa alaluvuissa.

Turvallisuus, läpinäkyvyys ja informoitu suostumus

Datan yksityisyyteen liittyvät kysymykset ovat tekoälytyökaluissa keskeisiä eettisiä haasteita. Haavoittuvassa elämäntilanteessa olevien tuen tarpeeseen liittyy usein arkaluontoisia asioita ja mahdollista stigmaa. Tällaisia tietoja sisältävän datan säilyttämiseen ja käsittelyyn liittyy siis paljon eettisiä haasteita. (Han, Mendu, Jaworski, Owen & Abdullah 2024, 11; Mielismäki & Husso 2025, 4–5.) Käyttäjien suojana tuleekin olla vähintään lain edellyttämät yksityisyyden suojat, kuten GDPR (Rizzo, Mozgai, Sigaras, Rubin & Jotwani 2025, 214–215). Lähisuhdeväkivaltaa käsittelevissä artikkeleissa nostettiin esille myös turvallisuusriskit liittyen teknologiavälitteiseen väkivaltaan, jolloin käyttäjän laitteiden yksityisyys voi olla esimerkiksi vakoilusovelluksen vuoksi vaarantunut. Tällöin samat työkalut, jotka voisivat auttaa henkilöä voivat myös vahingoittaa häntä. (Mielismäki & Husso 2025, 4, 12–13; Lombard, Butterby, Mielismäki, Vicente-García & Pérez-Martínez 2025, 4, 10, 13.)

Luottamus on perusta hyvälle palvelukokemukselle ja toimivalle tuelle etenkin haavoittuvassa elämäntilanteessa olevien ihmisten kohdalla, kun luottamuksen särkyminen voi aiheuttaa erityisen suurta vahinkoa (Mielismäki & Husso 2025, 4). Olennaisia luottamuksen rakentajia ovat informoitu suostumus ja palvelun läpinäkyvyys. Käyttäjälle tulisi kertoa selkeästi mitä dataa ja mihin tarkoitukseen hänestä kerätään ja miten sitä säilytetään. (Han ym. 2024, 11–13; Coghlan ym. 2023, 6.) Mikäli chatbot ja siihen liittyvä tieto on epäselvää tai vaikeasti löydettävää, ei käyttäjälle synny luotettavaa kuvaa palvelusta tai sitä tarjoavasta toimijasta. Läpinäkyvyyttä tulee harjoittaa myös siinä, että käyttäjää informoidaan selkeästi, että kyseessä on tekoälykeskustelija eikä ihminen, kuten myös tekoälyn rajoitteista, kuten virhetulkintojen riskistä ja eroista ihmisen kanssa asiointiin (Mielismäki & Husso 2025, 5; Coghlan ym. 2023, 212–213). Myös läpinäkyvyys AI-chatbotin toiminnallisuuksista, kuten käytetyistä kielimalleista ja turvatoimenpiteistä (esimerkiksi itsetuhoisuuteen liittyvissä aiheissa) vahvistaa luotettavuutta ja eettistä kestävyyttä (van Kolfschooten, Gonçalves, Orchard & Figueroa 2025, 5).

Vinoumat voivat estää yhdenvertaisuuden toteutumista

Oikeudenmukaisuuteen liittyvä eettinen periaate vaatii ihmisten yhdenvertaista kohtelua (Floridi & Cowls 2019, 5; Mielismäki & Husso 2025, 5). AI-chatbotin ja sen eri osa-alueiden toimintaan ja kehittämiseen käytetty data ja algoritmit voivat heijastaa ja vahvistaa yhteiskunnassa tai kulttuurissa olemassa olevia marginalisoituihin ihmisryhmiin liittyviä haitallisia käsityksiä ja (tiedostamattomia) vinoumia, mikä voi johtaa syrjintään. Kielimallit operoivat todennäköisyyksien ja assosiaatioiden varassa, minkä vuoksi ne voivat toistaa käyttämässään datassa ilmeneviä vahingollisia näkemyksiä, kuten alistavaa sukupuolijärjestelmää tai valkoiseen ylivaltaan liittyviä sortavia asenteita. (Mielismäki & Husso 2025, 5; Vicsek, Zajko, Vancsó, Takacs & Annus 2025, 3.) Tämä on todennäköistä varsinkin silloin, kun moninaisuuteen ei ole kiinnitetty tekoälyn kouluttamis- ja testaamisvaiheessa tietoista huomiota (Coghlan ym. 2023, 6). Vinoumat voivat olla myös epäsuoria ja liittyä representaatioon: keskusteleeko chatbot esimerkiksi aina heteronormatiivisesta, valkoisesta tai mieskeskeisestä näkökulmasta, mikäli muuta ei eksplisiittisesti määritetä (Vicsek ym. 2025, 3–4)?

Sosiaali- ja terveysalan kontekstissa toiminnan keskiössä on universaalit ihmisoikeudet, kuten oikeus tasavertaiseen ja syrjimättömään kohteluun (Ks. esim. Mielismäki & Husso 2025, 5). Vicsek ym. tarkastelivat AI-chatbottien LGBTQ-vihamielisiä vinoumia erilaisissa uskonnollisissa ja kulttuurisissa konteksteissa sekä ilman kontekstia ja havaitsivat, että etenkin uskonnollisen kontekstin mukaan tuominen vähensi chatbottien eksplisiittistä tukea LGBTQ-ihmisiä kohtaan. Vaikka suora tuki vihamielisille näkemyksille oli eri testiasetelmissa vähäistä, vaikuttaa siltä, että chatbotit tulkitsevat uskonnollisen tai kulttuurisen kontekstin ainakin jossain määrin selittävänä ja sallivana tekijänä vihamielisille ja syrjiville näkemyksille. (Vicsek ym. 2025, 7–10.) On mahdollista, että sama salliva suhtautuminen syrjiviä asenteita kohtaan toistuu myös muissa kuin uskonnolliskulttuurisissa konteksteissa.

Integroiminen palvelujärjestelmään ja prosessiin

AI-chatbottien ei tulisi korvata ihmisiltä saatua tukea haastavissa elämäntilanteissa, vaan niiden tulisi täydentää olemassa olevia tukipalveluita, integroitua kiinteästi osaksi palvelujärjestelmää sekä tarjota näitä tarvittaessa aktiivisesti vaihtoehtona (Mielismäki & Husso 2025, 16; Han ym. 2024, 13; Rizzo ym. 2025, 214). Sen tulisi myös olla jatkuvassa valvonnassa ja vuorovaikutuksessa siitä vastaavien ammattilaisten kanssa, jotka varmistavat muun muassa sen asianmukaisen toiminnan ja tiedon oikeellisuuden. Tärkeintä inhimillinen interventio on teemoissa, joihin liittyy erityisiä riskejä (esim. itsetuhoisuus). Tekoälyn ei tulisi tehdä arvioita, ratkaisuja tai päätöksiä (esim. diagnoosin määrittäminen potilaalle), vaan tällaisissa tilanteissa tulisi käyttää aina ihmiskeskeistä ammattilaisen konsultointia. (Rizzo ym. 2025, 214–216; Coghlan ym. 2023, 5; van Kolfschooten ym. 2025, 6.) Ihmiskeskeisen tuen tarjoaminen lisää myös saavutettavuutta, mikäli palvelun käyttäjällä on esimerkiksi puutteellinen osaaminen tietotekniikan suhteen (Han ym. 2024, 13).

Haasteena ihmiskeskeisten palveluiden ensisijaisuudelle voi kuitenkin olla palvelujärjestelmän kuormittuneisuus, pirstaleisuus ja puutteellisuus (ks. esim. Mielismäki & Husso 2025, 14–15). Pahimmassa tapauksessa AI-chatbotin valvontaan liittyvät tehtävät vievät resursseja muulta työltä, johon niitä oli jo valmiiksi liian vähän (Coghlan ym. 2023, 5). Tosiasiallisesti riskinä voi siis olla, että tekoälyratkaisuilla korvataan ihmisosaamista siellä, missä resursseista on pulaa.

Robotti, ihminen vai ihmisenkaltainen robotti?

Ihmisen ja AI-chatbotin eroihin liittyvät teemat korostuivat erityisesti lähisuhdeväkivaltaa käsittelevissä artikkeleissa, koska niissä yhdistyvät kokonaisvaltainen tilannearviointi, traumaattisten kokemusten vaikutus ja väkivallan riskien hahmottaminen. Tällaisessa haastavassa tukityössä kokemuksen tuoman empiirisen tietotaidon tärkeys korostuu, sillä työ vaatii hyvää arviointikykyä ja syvällistä ymmärrystä lähisuhdeväkivallan dynamiikasta. Tekoäly ei kerrytä osaamistaan ja kokemustaan ihmisen tavoin, eli se ei opi ymmärtämään käsittelemiään ilmiöitä ajan myötä syvällisemmin. Myös tilannesidonnaisten muuttujien ja ongelmien monimutkaisuuden ymmärrys on tärkeää, samoin kuin kyky kehittää niihin luovia ratkaisuja dialogisessa yhteistyössä ammattilaisen ja palvelun käyttäjän välillä. (Mielismäki & Husso 2025, 12.) Herää siis kysymys siitä, onko chatbottiin mahdollista siirtää ammatillinen kokemus ja hiljainen tieto riittävällä tavalla.

Yhteys ihmiseen nähdään erityisen tärkeänä juuri haavoittuvissa elämäntilanteissa, kuten traumaattisista kokemuksista tai mielenterveyden haasteista toipumisen tukemisessa, koska tekoäly ei kykene tuottamaan aitoa emotionaalista yhteyttä tai empatiaa, joka on toipumisen tuessa usein tärkeä tekijä. AI-chatbot ei kykene havainnoimaan luotettavasti esimerkiksi non-verbaalista viestintää tai vuorovaikutuksen vivahteita (esim. painotus, välttely) samoin, kuin kohtaamistyön ammattilainen. (Lombard ym. 2025, 10–11; Coghlan ym. 2023, 5.) Esimerkiksi lähisuhdeväkivaltatilanteissa harjaantunut ammattilainen saattaa tunnistaa väkivallan ensimmäiset merkit hyvin pienistä seikoista, joita voi olla vaikeaa sanoittaa (Mielismäki & Husso 2025, 13).

AI-chatbotteihin liittyy myös korkea väärintulkinnan riski sekä chatbotin että käyttäjän osalta. Chatbot voi tulkita keskustelun väärin tai hakea tietoa väärästä paikasta, jolloin sen antama vastaus voi olla harhaanjohtava. Joissain tilanteissa väärillä ohjeilla voi olla vakavia seurauksia palvelun käyttäjälle, jos ne liittyvät esimerkiksi terveyteen tai turvallisuuteen. (Lombard ym. 2025, 11.) Pahimmillaan siis hyvään tarkoitukseen luotu palvelu voi aiheuttaa tahatonta vahinkoa käyttäjälleen (Coghlan ym. 2023, 5). Toisaalta vuorovaikutukseen liittyvät vaikeudet voivat myös käännyttää käyttäjän pois palvelusta, koska sen käyttö koetaan turhauttavaksi ja vaikeaksi. Tämä on erityisen yleistä digitaalisissa palveluissa, joista poistuminen on helppoa. (Mielismäki & Husso 2025, 17.) Poiskäännyttävä kokemus, vaikka kyseessä olisi vain ”robotti”, voi nostaa haavoittuvassa elämäntilanteessa olevan kynnystä avun hakemiseen.

Vastuun ja autonomian tasapaino

Autonomia ja vastuu kulkevat erilaisissa tukipalveluissa käsi kädessä. Ammattilaisilla on usein lakisääteisiä tai muita velvollisuuksia puuttua tietynlaisiin tilanteisiin (esim. lastensuojelullinen huoli), jolloin tasapainotellaan ammattilaisen vastuun ja palvelun käyttäjän autonomian välillä. Toisaalta ammattilaisen vastuunotto voi myös tukea käyttäjän autonomiaa, jos se edistää hänen toimintakykyään esimerkiksi tarpeenmukaisen tuen saamisen myötä. Toimintakyvyn ja toimijuuden, eli autonomian, tukeminen on esimerkiksi sosiaalityön ytimessä. Koska anonyymissä chatbot-palvelussa ammattilaisen väliintulo ei ole samalla tavalla mahdollista, vastuu kaikesta toiminnasta ja tuen hankkimisesta jää kokonaan palvelun käyttäjälle, jonka toimintakyky on mahdollisesti jo heikentynyt. (Mielismäki & Husso 2025 5, 11, 14, 17.)

Palvelun läpinäkyvyydellä on yhteys autonomian toteutumiseen: jos AI-chatbotin toiminta on epäselvää ja läpinäkymätöntä, käyttäjä ei voi tehdä aidosti informoitua päätöstä sen käytöstä. AI-chatbottien tarjoamat vastaukset ovat usein melko yleistasoisia, millä voi olla negatiivista vaikutusta käyttäjän autonomiaan, koska palvelu ei tue häntä tekemään informoituja valintoja tilanteessaan. Geneeriset neuvot ilman konkreettista tukea voivat pahimmillaan syventää palvelun käyttäjän ongelmia, joihin hän hakee apua. (van Kolfschooten ym. 2025, 3–4, 6.)

Palvelun käyttäjän autonomian tukemisen lisäksi AI-chatbotin tarjoajalla on vastuu varmistaa chatbotin käytön turvallisuus. Chatboteissa saatetaan käyttää tietynlaisena vastuuvapauslausekkeena ilmoitusta siitä, että tekoäly voi tehdä virheitä. Ongelmana tässä on se, että vastuu tiedon oikeellisuuden varmistamisesta jää viimekädessä palvelun käyttäjälle. (van Kolfschooten ym. 2025, 5; Mielismäki & Husso 2025, 15–16.) Tekoälyratkaisuiden osalta on tärkeää määrittää selkeät käytännöt ja vastuutahot niiden asianmukaisen toiminnan seurantaan ja valvontaan. Kehittämisessä ja arvioinnissa on hyvä hyödyntää yhteiskehittämistä. Lisäksi on tärkeää mahdollistaa käyttäjälle helppo tapa antaa palautetta, jota hyödynnetään jatkokehittämisessä. (van Kolfschooten ym. 2025, 5; Rizzo ym. 2025, 212, 214, 217.)

Johtopäätökset ja pohdinta

Kuvailevan kirjallisuuskatsauksen tuloksena saatiin viisi temaattista kategoriaa, jotka esiteltiin tässä artikkelissa konkreettisten esimerkkien avulla. Temaattisista kategorioista muodostettiin yhdeksän eettistä näkökulmaa, jotka tulee huomioida tekoälypohjaisen chatbotin kehitystyön riskianalyysissa merkittävinä riskitekijöinä, erityisesti kehitettäessä palvelua haavoittuvassa asemassa olevalle kohderyhmälle. Nämä yhdeksän tunnistettua näkökulmaa on esitelty Kuviossa 2.

Kuvio 2. Eettiset näkökulmat tekoälychatbotin kehittämistyön riskianalyysin tueksi

Eettiset näkökulmat eivät kuitenkaan ole toisiaan poissulkevia. Päinvastoin näkökulmien välillä on osin suuriakin liitännäisyyksiä tai riippuvuuksia. Tekoälypohjaisen chatbotin vastuullisessa kehittämisessä näkökumien huomioiminen korostuu. Riskianalyysissä tarkastelun rinnalle on nostettava haavoittuvassa elämäntilanteessa olevan kohderyhmän erityistarpeet ja -vaatimukset palvelulle.

Kuvion 2 ylimmällä rivillä olevat näkökulmat liittyvät pitkälti ihmisten perusoikeuksiin, niiden suojelemiseen ja turvaamiseen sekä yleisesti tietoisuuden ja turvallisuuden tunteen lisäämiseen esim. avoimuuden avulla. Keskimmäisellä rivillä on näkökulmia, jotka tulisi aina kehitystyössä huomioida, mutta erityisesti palveluita kehitettäessä haavoittuvassa asemassa oleville on suuri riski väärinymmärrykseen, väärintulkintaan tai jopa vääriin olettamuksiin ja johtopäätöksiin. Alimmalla rivillä on näkökulmia, joiden merkitys korostuu työskenneltäessä haavoittuvassa tilanteessa olevan henkilöiden kanssa. Riskiperustaisessa tarkastelussa näiden näkökulmien kohdalla on mahdollistettava ja laitettava etusijalle ammatti-ihmisen interventio syvällisen ymmärryksen, inhimillisyyden ja empatiakyvyn turvaamiseksi.

Dataturvallisuuteen ja yksityisyyteen liittyvät kysymykset toistuivat aineistossa eniten, ja tämä lienee myös yleisessä keskustelussa eniten puhututtava keskustelevaan tekoälyyn liittyvä eettinen haaste. Haavoittuvassa elämäntilanteessa tukipalveluita tarvitsevan on usein välttämätöntä jakaa hyvinkin arkaluontoisia tietoja, minkä vuoksi yksityisyyden turvaamiseen liittyvät asiat korostuvat erityisesti. Näissä tilanteissa myös palveluun liittyvät kokemukset turvattomuudesta ja luottamuksen rikkomisesta voivat aiheuttaa huomattavan vakavia seurauksia ja nostaa kynnystä avun hakemiseen tilanteen pahentuessa. Tekoälytyökalulla voidaan siis hyvästä tarkoituksesta huolimatta aiheuttaa tahatonta haittaa. Kohderyhmän tilanteisiin liittyvien riskien ja turvattomuuden tunteminen on palvelua kehittäessä tärkeää. Näin varmistetaan muun muassa pahan välttämisen, autonomian ja selitettävyyden eettisten periaatteiden mukainen kehittämistyö (vrt. Floridi & Cowls 2019, 4–5).

Yksityisyyteen liittyy vahvasti myös vastuukysymykset ja palvelun luotettavuus. Luotettavuutta vahvistaa läpinäkyvyys ja informatiivisuus, jolloin käyttäjä pystyy tekemään itselleen sopivimpia ratkaisuja. Chatbotteihin liittyvät vastuukysymykset ovat monin tavoin samoja, kuin ihmislähtöisissä palveluissa: kenen vastuulla on, jos palvelua tarjoava henkilö tekee virheen tai aiheuttaa vahinkoa? Tekoälypalveluiden kohdalla erona on se, että tekoäly ei itse voi olla vastuussa tekemisistään, koska se ei ole itsenäinen toimija samoin kuin ammattilainen on. Tekoälyn virheistä ei voida yksinkertaisesti irtisanoutua vastuuvapauslausekkeilla, jolloin lopullinen vastuu sysätään käyttäjälle.

Vastuu toiminnasta palvelun käytön jälkeen jää käytännössä täysin palvelun käyttäjälle. Haavoittuvien elämäntilanteiden kontekstissa se voi olla joskus ongelmallista, koska käyttäjän voimavarat ja toimintakyky voivat olla vähäiset, jolloin hän kaipaisi intensiivisempää saattaen ohjausta. Tässä kohtaa onkin tärkeää, että tekoälypalvelut ovat nimenomaan vaihtoehto ihmiskeskeisille palveluille, ja niitä on myös tarjolla saavutettavasti ja matalalla kynnyksellä.

Syrjivien vinoumien toistaminen on yksi keskustelevaan tekoälyyn liittyvä ongelma, joka voi haastaa oikeudenmukaisuuden tai reiluuden eettisiä periaatteita. Aineistossa näkyi, että vinoumat näyttäytyvät varsin harvoin eksplisiittisenä syrjintänä, vaan ennemminkin syrjivien ajatusmallien selittelyn ja oikeutuksen hyväksymisenä esimerkiksi kulttuurisiin tai uskonnollisiin seikkoihin pohjautuen. Havainto korostaa chatbotin ja ihmisen eroa: ammattilaiselta voi odottaa kykyä hallinnoida kokonaista arkaluontoisiin aiheisiin liittyvää keskustelua, suunnitella keskustelun suuntaa ja sisältöä keskustelun aikana ja huomioida asioita, joita keskustelussa on tärkeää käsitellä sivuuttamatta. Auttamistyötä tekevän ammattilaisen ammattitaitoon kuuluu kyky ohjata keskustelua olennaisiin asioihin ja haastaa vahingollisia ajatusmalleja, liittyivät ne sitten asiakkaaseen itseensä tai muihin ihmisiin, sensitiivisellä lähestymistavalla ja dialogisesti. Chatbot puolestaan etenee keskustelussa prompti kerrallaan eikä samalla tavoin tietoisesti ohjaa keskustelun kulkua relevantteihin aiheisiin tai palaa aiemmin puhuttuun aiheeseen myöhemmin keskustelun aikana.

Ihmisen ja chatbotin erot korostuvat tilanteissa, jotka vaativat syvällisen ymmärryksen lisäksi empatiakykyä tai inhimillistä läsnäoloa. Ihminen kykenee vuorovaikutustilanteessa hallitsemaan suuria ja mutkikkaita kokonaisuuksia, hahmottamaan erilaisia yhteenliittymäkohtia ja systeemisiä yhteyksiä. Kohdatuksi ja kuulluksi tuleminen sekä aidon empatian kokeminen on haavoittuvissa elämäntilanteissa usein jo itsessään korjaava kokemus, mikä chatbotissa jää pois, vaikka se kykenisikin näitä tunnekokemuksia simuloimaan. Tämän vuoksi auttamistyössä tekoälypohjaisten palveluiden käyttökohteet tulee suunnitella huolellisesti ja pitää rajattuna, mistä täytyy myös viestiä palvelun käyttäjälle selkeästi ja tehokkaasti. AI-chatboteilla ei tule pyrkiä korvaamaan ihmisten tarjoamia psykososiaalisen tuen palveluita tai paikkaamaan vajavuuksia henkilöstöresursseissa, vaan tarjoamaan vaihtoehtoinen palvelu etenkin varhaisen tuen vaiheessa palveluun hakeutumisen kynnyksen madaltamiseksi sekä luotettavan ja nopean tiedonsaannin helpottamiseksi.

Lähteet

Caballar, R.D. i.a.. Generative AI vs. predictive AI: What’s the difference? IBM. Viitattu 19.12.2025 https://www.ibm.com/think/topics/generative-ai-vs-predictive-ai-whats-the-difference#257779833.

Castrén, E. 2021. Haavoittuvassa asemassa olevien tunnistamista on parannettava maastapoistamisessa. Yhdenvertaisuusvaltuutettu 8.7.2021, Viitattu 19.12.2025 https://yhdenvertaisuusvaltuutettu.fi/-/haavoittuvassa-asemassa-olevien-tunnistamista-on-parannettava-maastapoistamisessa-.

Chow, A.R. 2025. ChatGPT May Be Eroding Critical Thinking Skills, According to a New MIT Study. Time Magazine 23.6.2025. Viitattu 8.9.2025 https://time.com/7295195/ai-chatgpt-google-learning-school/.

Coghlan, S., Leins, K., Sheldrick, S., Cheong, M., Gooding, P. & D’Alfonso, S. 2023. To chat or bot to chat: Ethical issues with using chatbots in mental health. Digital Health, Vol 9. https://doi.org/10.1177/20552076231183542.

DIGISOS 2023-2025. DigiSos-hanke – Digitaalisen väkivallan tunnistaminen ja siihen puuttuminen sosiaali- ja terveysalalla. Viitattu 15.1.2026 https://projects.tuni.fi/digisos/

Eskola, J. & Suoranta, J. 1998. Johdatus laadulliseen tutkimukseen. Osuuskunta Vastapaino. Tampere.

EU 2024/1689. Euroopan parlamentin ja neuvoston asetus (EU) 2024/1689 tekoälyä koskevista yhdenmukaistetuista säännöistä. Viitattu 16.1.2026 https://eur-lex.europa.eu/legal-content/FI/TXT/?uri=CELEX:32024R1689

Floridi, L. & Cowls, J. 2019. A Unied Framework of Five Principles for AI in Society. Harvard Data Science Review, Vol 1 Nro 1, 1–15. https://doi.org/10.1162/99608f92.8cd550d1.

Han, H. J., Mendu, S., Jaworski, B. K., Owen, J. E. & Abdullah, S. 2024. Assessing acceptance and feasibility of a conversational agent to support individuals living with post-traumatic stress disorder. Digital Health, Vol 10. https://doi.org/10.1177/20552076241286133.

High‐Level Expert Group on AI 2019. Ethics guidelines for trustworthy AI. Euroopan komissio. https://doi.org/10.2759/346720

Hyväri, S. 2021. Myytti: Haavoittuvassa asemassa oleva asiakas ei ole omien palveluidensa asiantuntija. Dialogi 5.2.2021. Viitattu 19.12.2025 https://dialogi.diak.fi/2021/02/05/myytti-haavoittuvassa-asemassa-oleva-asiakas-ei-ole-omien-palveluidensa-asiantuntija/.

Kangasniemi, M., Utriainen, K., Ahonen, S-M., Pietilä, A-M., Jääskeläinen, P. & Liikanen, E. 2013. Kuvaileva kirjallisuuskatsaus: eteneminen tutkimuskysymyksestä jäsennettyyn tietoon. Hoitotiede, Vol 25 Nro 4, 291–301. Viitattu 19.12.2025 https://journal.fi/hoitotiede/article/view/128286.

van Kolfschooten, H., Gonçalves, J., Orchard, N. & Figueroa, C. 2025. AI chatbots for promoting healthy habits: Legal, ethical, and societal considerations. Digital Health, Vol 11. https://doi.org/10.1177/20552076251390004.

Lombard, N., Butterby, K., Mielismäki, H., Vicente-García, R. & Pérez-Martínez, V. 2025. Introducing a Chatbot to Support Victim-Survivors of Domestic Abuse: Victim-Survivor Perspectives. Violence Against Women, Vol 0. https://doi.org/10.1177/10778012251363583.

Mielismäki, H. & Husso, M. 2025. Ethical Implications of AI‐Driven Chatbots in Domestic Violence Support. Social Inclusion, Vol 13 Article 9998. https://doi.org/10.17645/si.9998.

Montgomery, B. 2025. AI companies start winning the copyright fight. The Guardian 1.7.2025. Viitattu 8.9. https://www.theguardian.com/technology/2025/jun/30/ai-techscape-copyright.

Puusa, A. & Juuti, P. (toim.) 2020. Laadullisen tutkimuksen näkökulmat ja menetelmät. Gaudeamus Oy, Helsinki.

Ren, S. & Wierman., A. 2024. The Uneven Distribution of AI’s Environmental Impacts. Harvard Business Review 15.6.2024. Viitattu 8.9.2025 https://hbr.org/2024/07/the-uneven-distribution-of-ais-environmental-impacts.

Rizzo, A., Mozgai, S., Sigaras, A., Rubin, J. E. & Jotwani, R. 2025. Expert Consensus Best Practices for the Safe, Ethical, and Effective Design and Implementation of Artificially Intelligent Conversational Agent (i.e., Chatbot/Virtual Human) Systems in Health Care Applications. Journal of Medical Extended Reality, Vol 2, Nro 1. https://doi.org/10.1177/29941520251369450.

SAP 2024. What is conversational AI? 11.6.2024. Viitattu 19.12.2025 https://www.sap.com/resources/what-is-conversational-ai.

Sisäministeriö 2021. Selvitys haavoittuviin ryhmiin kuuluvien turvallisuuden kokemuksista. Sisäministeriön julkaisuja 2021:21. Helsinki. https://urn.fi/URN:ISBN:978-952-324-320-0.

Stanford University 2024. Privacy in an AI Era: How Do We Protect Our Personal Information? 18.3.2024. Viitattu 8.9.2025 https://hai.stanford.edu/news/privacy-ai-era-how-do-we-protect-our-personal-information.

Stryker, C. i.a. What are large language models (LLMs)? IBM. Viitattu 19.12.2025 https://www.ibm.com/think/topics/large-language-models#692473873.

Stryker, C. & Holdsworth, J. i.a. What is NLP (natural language processing)? IBM. Viitattu 19.12.2025 https://www.ibm.com/think/topics/natural-language-processing#1197505092.

Stryker, C. & Scapicchio, M. i.a. What is Generative AI? IBM. Viitattu 19.12.2025 https://www.ibm.com/think/topics/generative-ai#:~:text=AI%20has%20been%20a%20hot,%C2%B9.

Terveyden ja hyvinvoinnin laitos i.a.a. Keskeisiä käsitteitä. Viitattu 19.12.2025 https://thl.fi/aiheet/hyvinvoinnin-ja-terveyden-edistamisen-johtaminen/hyvinvointijohtaminen/hyvinvointi-ja-terveyserot/keskeisia-kasitteita.

Terveyden ja hyvinvoinnin laitos i.a.b. Haavoittuvat ryhmät. Viitattu 19.12.2025 https://thl.fi/tutkimus-ja-kehittaminen/tutkimukset-ja-hankkeet/vakivallaton-lapsuus-toimenpidesuunnitelma/haavoittuvat-ryhmat.

Tilastokeskus 2025. Väestön tieto- ja viestintätekniikan käyttö. Katsaus 12.11.2025. Viitattu 15.1.2026 https://stat.fi/julkaisu/cmh32zpp67l1z07w6yfukiiqd

Vicsek, L., Zajko, M., Vancsó, A., Takacs, J. & Annus, S. 2025. Cross-cultural challenges in generative AI: Addressing homophobia in diverse sociocultural contexts. Big Data & Society, Vol 12, Nro 4. https://doi.org/10.1177/20539517251396069.

Wei, M. 2025. The Emerging Problem of “AI Psychosis”. Psychology Today. Viitattu 1.9.2025 https://www.psychologytoday.com/us/blog/urban-survival/202507/the-emerging-problem-of-ai-psychosis.

Yousif, N. 2025. Parents of teenager who took his own life sue OpenAI. BBC News. Viitattu 1.9.2025 https://www.bbc.com/news/articles/cgerwp7rdlvo.

Asiasanat: chatbot, eettisyys, ennakointi, haavoittuvuus, kehittäminen, palvelujärjestelmät, tekoäly, vastuullisuus, yhdenvertaisuus